OpenAI全量上线4o视频通话 - 我们等了7个月。

关注+2024-12-13作者:路西蓝

Day4是个很无聊的canvas的极小更新以及向全量用户开放,昨晚Day5完全就是给苹果做下PR,都是纯粹的垃圾时间。

而今天,4o的实时视频通话,终于来了。

是不是感觉有点陌生?没想到吧,4o居然还有实时视频通话。。。

鸽了7个月,快被人忘干净了。

总结一下今天的直播,有三个东西:

实时视频通话。

实时理解屏幕。

圣诞老人限定语音。

一个一个说吧。

一.实时视频通话

今年5月14日,OpenAI的春季发布会上,他们正式掏出了GPT-4o。

fmt=other&from=appmsg&tp=webp&wxfrom=5&wx_lazy=1&wx_co=1" data-w="1080" data-original-="" data-index="1" src="https://pic.chinaz.com/2024/1213/2024121308404897090.jpg" _width="677px" alt="图片" data-fail="0" style="margin: 0px auto; padding: 0px; box-sizing: border-box; outline: 0px; border: 1px solid rgb(238, 238, 238); --tw-shadow: 0 0 #0000; --tw-ring-inset: var(--tw-empty, ); --tw-ring-offset-width: 0px; --tw-ring-offset-color: #fff; --tw-ring-color: rgba(41, 110, 228, 0.5); --tw-ring-offset-shadow: 0 0 #0000; --tw-ring-shadow: 0 0 #0000; max-width: 700px; background: url("../img/bglogo2.svg") center center no-repeat rgb(247, 248, 249); box-shadow: rgba(27, 95, 160, 0.1) 0px 1px 3px; display: inline-block;"/>

其中最酷的东西,当然是他们的原生多模态。

大家也都见识到了,高级语音模式的威力,能模仿情绪、能唱歌、能演戏。在小红书和X上,已经看到无数人,在用它来做情感陪伴、练口语等等。

在教育领域,绝对是一个巨大的大杀器。

但是其实,当时最让人兴奋的,还是实时视频。

CRMxge8m6cyuHKaEq1JkoWKIhXQID*PiaEozJGkmgb1sajBUcYzicfflU68RSGpQ/640?wx_FMt=png&from=appmsg" data-type="png" data-w="1080" data-original-="" data-index="2" src="https://pic.chinaz.com/2024/1213/2024121308404897091.jpg" _width="677px" alt="图片" data-fail="0" style="margin: 0px auto; padding: 0px; box-sizing: border-box; outline: 0px; border: 1px solid rgb(238, 238, 238); --tw-shadow: 0 0 #0000; --tw-ring-inset: var(--tw-empty, ); --tw-ring-offset-width: 0px; --tw-ring-offset-color: #fff; --tw-ring-color: rgba(41, 110, 228, 0.5); --tw-ring-offset-shadow: 0 0 #0000; --tw-ring-shadow: 0 0 #0000; max-width: 700px; background: url("../img/bglogo2.svg") center center no-repeat rgb(247, 248, 249); box-shadow: rgba(27, 95, 160, 0.1) 0px 1px 3px; display: inline-block;"/>

能实时对话,能理解你的连续性动作,能知道你在干啥。

也有记忆。

比如你跟他聊桌子上的一杯冰美式咖啡,这杯冰美式长的无头六臂奇奇怪怪颜色还是红色的,你们聊的很开心,然后切到了另一个话题,过了一分钟后,你突然问他,咱们刚才聊的咖啡是啥颜色。

它会很准确的告诉你,是红色。

就像,AI第一次,有了跟人类一样的眼睛。

他们自己也演示了一个很有趣的例子。

就是先让ChatGPT跟在座的人聊了一圈,然后问它:

而GPT回答的很好,直接把女生的名字回答的很准确,它记住了她。

然后又演示了另外一个当场教人做咖啡的场景。

VRxk5Wka2yzgboTTas2khliaR5LCbulTwvia3CGJ7vQ/640?wx_fmt=png&from=appmsg" data-type="png" data-w="1080" data-original-="" data-index="4" src="https://pic.chinaz.com/2024/1213/2024121308404897103.jpg" _width="677px" alt="图片" data-fail="0" style="margin: 0px auto; padding: 0px; box-sizing: border-box; outline: 0px; border: 1px solid rgb(238, 238, 238); --tw-shadow: 0 0 #0000; --tw-ring-inset: var(--tw-empty, ); --tw-ring-offset-width: 0px; --tw-ring-offset-color: #fff; --tw-ring-color: rgba(41, 110, 228, 0.5); --tw-ring-offset-shadow: 0 0 #0000; --tw-ring-shadow: 0 0 #0000; max-width: 700px; background: url("../img/bglogo2.svg") center center no-repeat rgb(247, 248, 249); box-shadow: rgba(27, 95, 160, 0.1) 0px 1px 3px; display: inline-block;"/>

我一直觉得,真正的实时视频理解,比语音和文本都重要的多。

因为对于我们人来说,从诞生到世界的第一天,当你还不会说话、还读不懂文字的时候,你理解这个世界,全靠视觉。

这是我们理解世界的基石。

而现在,当你举起一张手写的便签,它能立马看懂;当你你给它看一本杂志上的广告,它能分析背后的设计意图和话术风格;你对着镜头摆弄一件家里的小物件,它能指出其用途、历史、甚至给出改造建议。

这个东西,我觉得还是挺酷的。

今天晚上,他们正式宣布即将上线了。没错,是即将上线。。。

一周以内,对Pro和Plus用户开放。

OpenAI你是真的狗。

其实感觉以OpenAI这段时间直播的节奏,理论上这种功能,应该是跟o1pro和Sora类似,直播完后就直接全量上了。

但是有可能是受到了昨天Gemini2的冲击(他们也有视频理解),又或者是因为昨天早上ChatGPT的全线崩溃。

导致这一波节奏混乱,甚至,我都觉得今晚的直播,都是为了不显得自己丢人,临时换上来的。。。

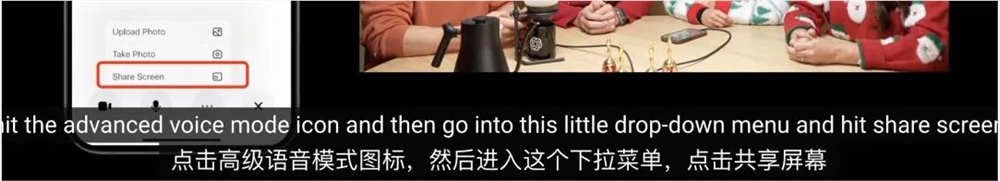

二.实时理解屏幕

一个基于实时视频理解的变种。

只不过一个是通过摄像头,看外部的现实世界,一个是通过类似于屏幕共享的方式,让它来看你的屏幕。

跟视频实时理解一下,一周内上线。

这个东西,我觉得非常有用,类似于给你一个随时待命给你建议的牛逼助理。

随时看着你的屏幕,然后给你指点。

比如说一些我能想到的最简单的应用场景。

你在写ppt,感觉这页怎么做怎么丑,有点卡壳时,你就可以问它:

"这页的视觉排版逻辑是不是有点问题?"或者"这个配色看起来怪怪的,有没有更好的推荐?"

它就能直接指出核心问题,比如某一页的文字太密集,这个标题应该放在左上角,配图应该换个写实风格的,甚至它还能帮你现场给你一个最优方案,把问题瞬间解决。

再比如,在你写代码的时候,屏幕共享开着,它能实时看你代码的进展,指出可能的错误,甚至直接告诉你哪些变量命名不规范,哪些逻辑可以优化。

你都不用自己debug,它直接化身你的leader,边看边指正。

还有一个我自己觉得最实用的场景,就是处理表格数据。

因为我经常会做各种奇奇怪怪的数据分析,打开Excel的时候真的满屏的数据让你头晕脑胀,这个时候你只需要说一声:

“这份报表有啥什么异值?”或者“能不能帮我画个趋势图?”

当它立马就能帮你分析数据并给出结论的时候,我觉得,这就是帮了我大忙了。

当然,我理想中的最完美的形态,还是跟类似于那种Computer Use的Agent结合,直接帮我把事干了,那才是我最想要的。

比如,我们在用Figma做界面设计的时候,设计到一半,感觉排版不太对劲,于是就可以直接对它说了一句:

“整体简约一点,字体换成无衬线体。”

它立马接管设计,调整了文字间距、对齐方式,还推荐了几种更适合的字体供选择,最终完成一个更专业的设计方案。

甚至,它还能帮你理解背后的设计逻辑那就更屌了。

比如你问它:“为什么这个排版显得更舒服?”

它还能从用户体验的角度出发,解释黄金分割、留白运用等理论,带你快速提升审美和技能。

这个,可能才是我最想要的未来。

也是我觉得,屏幕实时理解的终极形态。

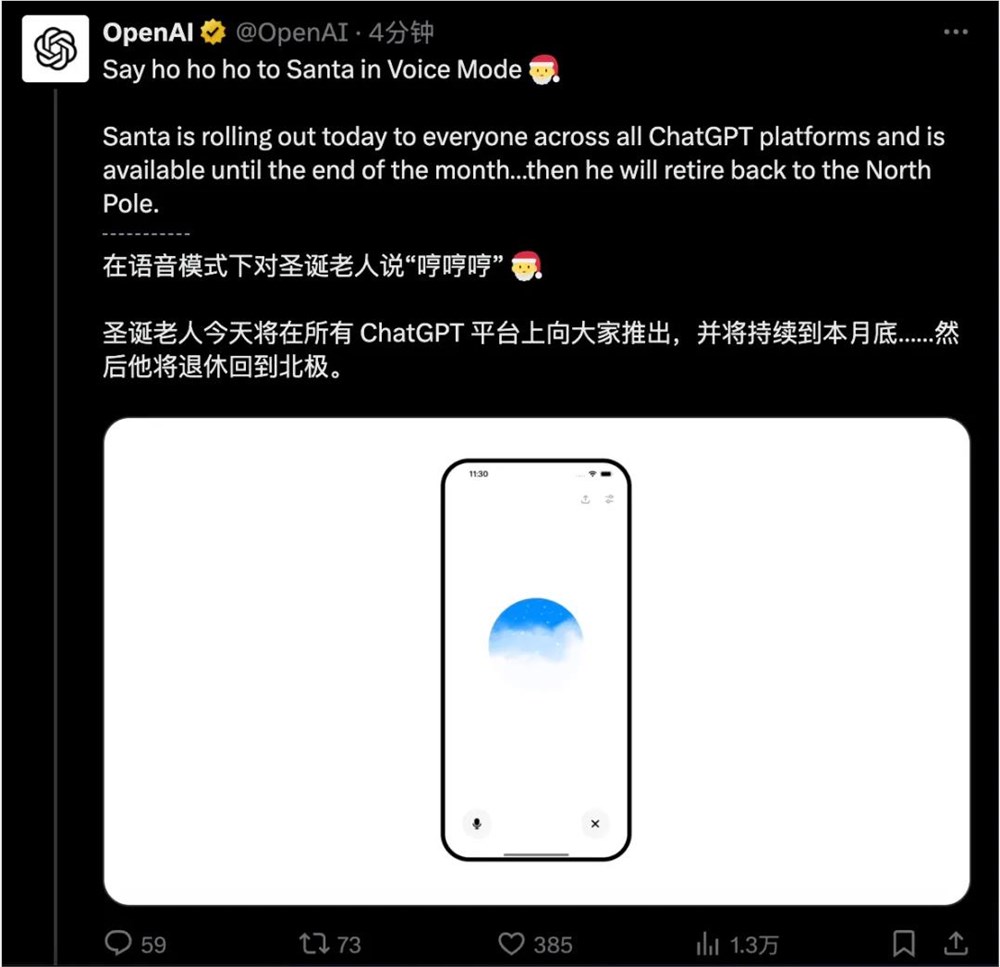

三.圣诞老人限定语音

一个挺抽象的更新,在高级语音里面,新加了一个新的音色。

叫Santa。其实就是个,圣诞老人的语音。

目前已经实时上线了,都可以在高级语音模式里体验到。

也挺抽象的,给大家听一听,我跟他的对话。。。

就,真的抽象。

可能对于老外来说,这个“吼~吼~吼”,真的有节日氛围吧。。。

写在最后

OpenAI直播,已经进行一半了。

稍微盘点一下。

Day1:满血o1上线,ChatGPT Pro会员上线,o1pro推出。

Day2:基于o1的强化微调。

Day3:Sora正式发布。

Day4:ChatGPT Canvas全员开放以及小功能更新。

Day5:给苹果站台,宣传苹果全系接入GPT。

Day6:4o的实时理解上线。

说实话,非常的低于预期,非常的不尽人意,非常的想让我骂他。

每天晚上,都是如坐针毡、如芒刺背、如鲠在喉。

Dalle4呢?AI Agent呢?AI搜索浏览器呢?猎户座新模型呢?

你这都是些啥啊。

最绝望的不是这个,最绝望的是,还有6天。

每天晚上我都会在小群里开腾讯会议,第一天来了80个人,第二天40个,第三天因为预告Sora也有40个,第四天20个,第五天11个。

而今天,只有5个。

真的,已经越来越没有人在乎了。

希望在后面的6天里,奥特曼你能改变一下我对于你的怨气,让我们觉得,OpenAI这么玩,都是策略,是在降低大家预期。

牛逼的东西,其实都放在后面。

真的,求求了。

为了你们自己。